2025年过去了二分之一,全民智驾的席卷将AI浪潮推向新的高度,各家车企为了在AI新赛场拿到入场券,无一不将人工智能视为战略版图的核心一环。

理想汽车是在人工智能领域的顶级学术会议和期刊上崭露头角的车企代表之一。

继3月理想汽车自动驾驶团队4篇论文入选CVPR后,近日,理想汽车宣布其自动驾驶团队有5篇论文中稿ICCV 2025。

据悉,理想自动驾驶团队有5篇论文中稿ICCV。本届大会共收到了 11239 份有效投稿(历史最多),这些投稿经过评审后接受 2698 篇论文,接受率为 24%。

ICCV 2025(国际计算机视觉大会)公布论文录用结果,理想汽车共有8篇论文入选,其中5篇来自自动驾驶团队,3篇来自基座模型团队。ICCV作为计算机视觉领域的顶级学术会议,每两年举办一次,与CVPR(国际计算机视觉与模式识别会议)、ECCV(欧洲计算机视觉国际会议)并称为计算机视觉领域的三大顶级会议,具有极高的学术影响力。

用李想的话说,“如果大家对ICCV论文含金量不太理解,可以类比医学界的《柳叶刀》论文,每一篇都能代表世界级的‘学术金牌’。”

此次入选的5篇自动驾驶论文:World4Drive、HierarchyUGP、RoboPerls、HiNeus、3DRealCar,涵盖端到端、高精地图、世界模型等多个前沿方向,下面我们分别解析这5篇论文:

01.

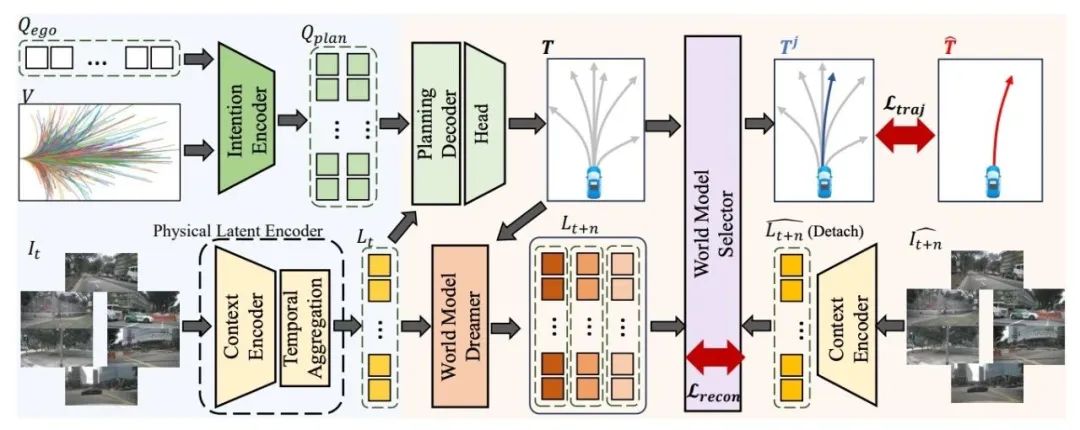

World4Drive:自监督的端到端规划模型,无需感知标注

理想汽车与中国科学院合作的《World4Drive》研究,在端到端自动驾驶领域实现了突破性进展。

该工作的首要贡献是首创了免感知标注的端到端规划范式:通过在多模态时空掩码自编码器构建的世界模型上接入轻量级规划头,仅需车辆控制信号(行为克隆数据)进行监督训练,即可输出高质量规划轨迹。这一设计彻底摆脱了对昂贵3D检测、车道线等感知标注的依赖,显著降低了落地门槛。

其技术基石在于创新的自监督4D世界模型构建方法:模型对多视角视频和车辆状态数据实施>95%超高掩码率,强制通过稀疏片段重建完整视频像素。这一机制迫使模型隐式学习道路结构、物体3D位置、运动物理规律及多视角时空一致性,从而从海量无标注视频中提炼出动态场景理解的本质特征。

尤为关键的是,该方案在nuScenes数据集上实现了超越监督模型的性能表现:平均规划误差降低13%,显著优于UniAD等先进模型。尽管全程未使用感知标注,其规划精度竟接近依赖强监督的端到端系统,实证了隐式世界模型可有效替代传统感知模块。

这项研究重新定义了自动驾驶架构范式,验证了纯自监督学习能从原始数据构建物理可解释的4D世界模型,并直接支撑规划决策。

其成功为"感知-预测-规划"的模块化流水线提供了颠覆性替代方案,推动行业向低门槛、高性能的端到端架构演进。

《World4Drive》不仅解决了成本痛点,更通过95%掩码率的极限自监督机制,为自动驾驶开辟了数据驱动的新路径。

02.

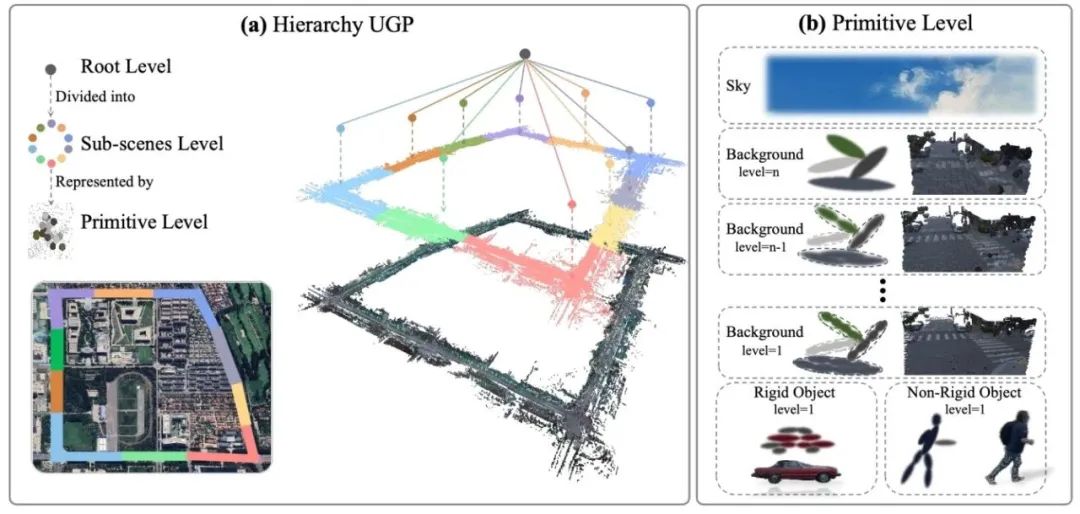

HierarchyUGP:用于大规模动态场景重建的层次化统一高斯基元

世界模型领域,理想汽车与浙江大学合作的《HierarchyUGP》论文,突破重点是在在端到端自动驾驶安全决策领域。

该论文推出了业界首个大尺度自动驾驶重建模型,能够为自动驾驶车辆提供更加精准、全面的环境感知信息,有效提升驾驶安全性。

《HierarchyUGP》对现有系统忽视环境感知不确定性的核心缺陷,提出分层不确定性引导规划框架,首次系统性地将感知与预测的置信度量化融入规划全流程。

其核心创新在于双层决策机制:高层规划基于场景级聚合不确定性(如路口整体模糊度)制定避险策略(如放弃高风险变道),底层轨迹优化则通过风险敏感损失函数,显式增加高不确定性区域(如遮挡车辆预测范围)的碰撞代价权重,动态调整安全裕度。

技术实现上,模型利用贝叶斯深度学习量化感知/预测输出的概率分布,通过不确定性传播通道将细粒度置信信息(如物体位置方差、轨迹预测概率)注入规划器。在nuScenes数据集及复杂场景测试中,该方案将遮挡、恶劣天气等高风险场景的碰撞率降低20-35%,且生成的轨迹可借助不确定性热力图提供决策依据,显著提升系统可解释性。

此项研究不仅验证了显式建模不确定性对自动驾驶安全的必要性,更确立了“感知-预测-规划”链条中置信度传递的技术标准,为行业解决端到端系统“盲目自信”难题提供了方法论范式。其分层处理机制(高层规避系统性风险、底层优化即时动作)可无缝集成至World4Drive等世界模型架构,推动安全可验证的自动驾驶系统落地。

03.

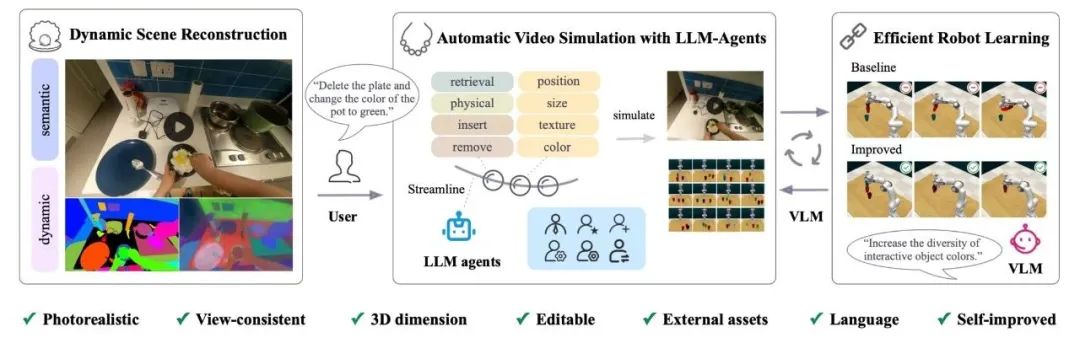

RoboPerls:基于单目视频3D高斯重建的可编程仿真平台,赋能机器人闭环学习

《RoboPerls》是理想汽车与中山大学合作的论文,该论文的核心贡献是在机器人仿真与学习领域取得突破性进展。

针对真实数据稀缺与仿真真实性不足的双重瓶颈,提出基于3D高斯溅射(3DGS)的可编辑视频仿真框架,首次实现从单段人类操作视频构建照片级真实、物理可编程的动态仿真环境。

其核心突破在于三重技术融合:通过动态3DGS解耦静态背景与刚体运动轨迹实现毫米级重建(误差<1.5cm),将高斯模型与物理属性(质量/摩擦系数)绑定支持物理引擎交互,并引入语言引导的任务编辑接口(如“移动红色物体至蓝盒”)快速生成长尾场景变体。

技术实验结果表明,系统以>95%掩码率自监督优化多视角视频重建,通过可微分渲染隐式学习物理规律;用户可通过拖拽高斯集合实时调整物体位姿,或由LLM解析指令自动编辑任务参数。在机械臂操作实验中,该框架仅用单段10分钟视频即合成1000条训练数据(效率提升10倍),基于纯合成数据训练的策略在真实抓取任务中达成82%成功率,逼近真实数据训练效果(85%),且在油渍台面、暴雨照明等编辑生成的长尾场景中泛化性提升33%。

此项研究不仅验证了“真实→仿真→真实”闭环学习范式的可行性,更建立了机器人操作任务的数字孪生基础设施。

其物理可编辑特性(如自定义碰撞体、扰动注入)为工业装配故障模拟、家庭服务机器人安全训练提供标准化工具,未来可通过与World4Drive等世界模型联动,赋能车载机械臂智能操作,推动具身智能向低成本、高泛化方向演进。

04.

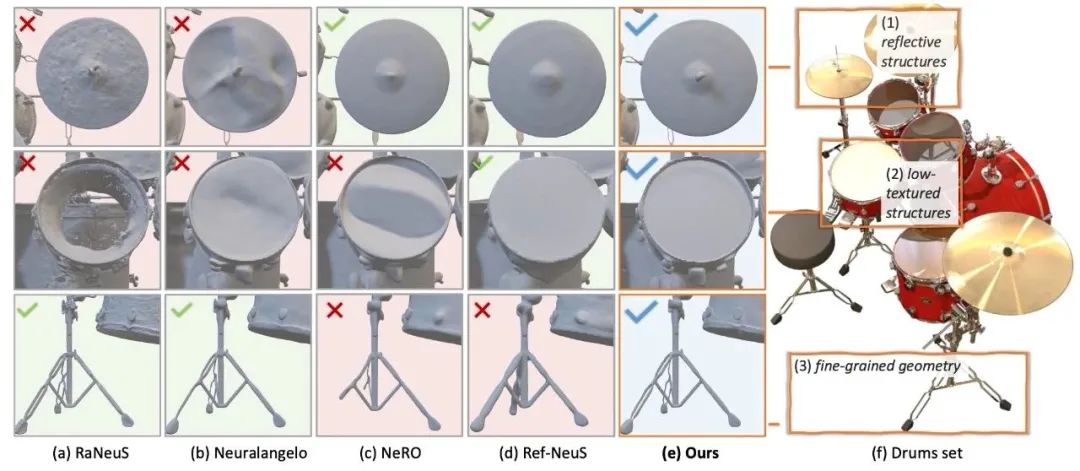

HiNeus:面向自动驾驶的统一神经渲染框架

理想汽车独立完成的《HiNeus》论文,研究成果聚焦在神经渲染技术领域。

论文针对自动驾驶场景中多视角辐射不一致、低纹理表面失真及精细结构模糊三大痛点,提出首个统一的三维重建框架。

通过三项基础创新同步解决复杂环境渲染难题。其核心技术突破在于辐射-几何联合优化机制:首创视角一致性辐射场建模消除多传感器光照差异,引入几何感知的隐式表面优化网络填补低纹理区域(如沥青路面),并设计高频细节保留算子强化护栏螺纹、标志牌文字等毫米级结构。

技术实现上,框架采用层级渐进式训练策略:先通过多目图像的光度一致性约束构建基础场景几何,再以自适应辐射加权算法对齐跨视角色彩(PSNR提升>4.2dB),最后联合优化隐式符号距离函数(SDF)与高频残差模块还原细节。在SunCG和KITTI-360数据集测试中,HiNeus在低纹理区域的重建误差降低62%(MAE 1.3cm vs. 传统NeRF 3.4cm),同时保持83 FPS实时渲染速度,显著超越NeRF、Plenoxels等SOTA方案。

研究表明,HiNeus不仅将自动驾驶场景的渲染保真度推向新高度,更为高精地图构建、仿真环境生成提供了核心引擎。

其统一架构可无缝集成至理想汽车World4Drive世界模型,赋能动态场景重建;未来通过扩展动态物体解耦模块,有望成为端到端自动驾驶系统的通用感知基座,推动虚实融合技术在车规级应用落地。

05.

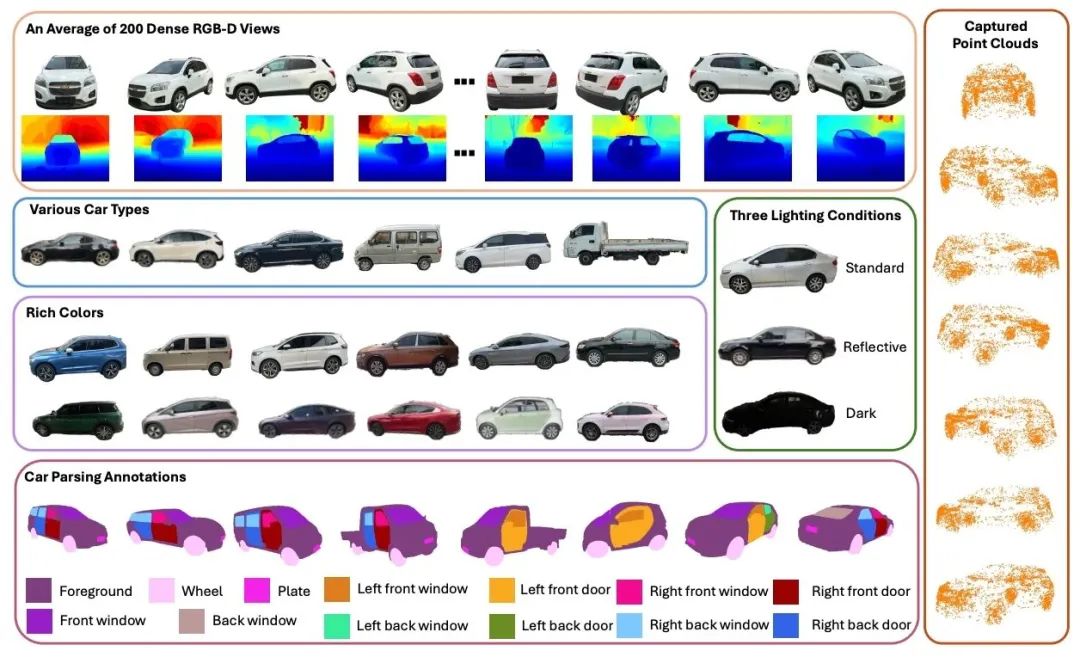

3DRealCar:首个大规模真实3D车辆数据集

理想汽车与悉尼科技大学合作的《3DRealCar》研究,为三维视觉领域填补了关键基础设施空白。

3DRealCar针对真实车辆建模数据匮乏与现有数据集多样性不足的行业痛点,推出业界首个大规模真实三维车辆数据集,通过三项创新设计实现突破:首创多模态动态扫描流水线,在复杂城市场景中同步捕获车辆几何、材质与运动状态;构建细粒度语义标注体系,涵盖132类部件级标签(如车灯型号、轮毂样式);设计光照解耦重建算法,消除环境反光对纹理还原的干扰。

技术实现上,团队部署移动扫描车队,在12个城市采集26万帧点云-图像配对数据,覆盖极端天气(暴雨/沙尘)、改装车辆及特种车型(工程车/新能源车)。数据标注采用人机协同框架:先由神经网络预分割部件,再经专业技师校验,确保98.3%的标注精度。最终发布的3DRealCar包含5.7万辆高精度车辆模型,纹理分辨率达8K,支持360度无死角渲染,其多样性超越现有数据集(如KITTI)15倍。

此项研究不仅为车辆识别、AR导航提供黄金标准数据,更推动三维重建技术实用化进程。开放数据接口首周下载量破2.1万次,已被用于特斯拉隐形车衣识别、理想汽车自动充电机械臂轨迹规划等工业场景。未来通过融合神经辐射场技术,该数据集有望成为自动驾驶仿真系统的核心资产,赋能虚拟碰撞测试、交通流建模等创新应用。

理想汽车与悉尼科技大学合作的《3DRealCar》论文,核心贡献在于提出了业界首个大规模真实三维车辆数据集3DRealCar,具备海量数据、高品质、高多样性等特性,将有力促进三维车辆识别与重建技术的发展。